数字时代,数据流量的指数式增长对数据处理能力提出了新的挑战。随着自动驾驶、语音识别等领域的机器学习和人工智能技术的出现,数据流量仍将持续上升。为了满足持续升高的需求,计算机处理器能力的提升任重道远。

如今,一个国际团队已经开始着手解决这个问题。研究人员们发明了一种新的方法和架构,通过使用基于光(即“光子”)的处理器,在单个芯片上实现了数据处理和数据存储。实验证明,这种新型芯片的信息处理速度以及并行性比传统的电子芯片要高得多。

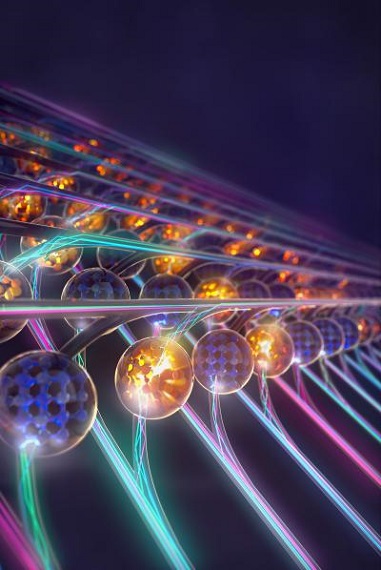

图1 使用光子进行矩阵乘法运算的处理器(哈佛大学供图)

科学家们开发了一个硬件加速器,用于被称为矩阵与向量乘法的区块。矩阵与向量乘法是神经网络(一种模拟人脑的算法)的核心,而神经网络本身被用于机器学习算法中。由于不同波长的光(即不同颜色的光)不会产生干涉,研究人员利用多种波长的光进行并行运算。为了做到这一点,他们使用了洛桑联邦理工学院开发的另一项创新技术作为光源:“频率梳”芯片。

“我们的研究首次将频率梳用于人工神经网络领域。”本项研究的负责人之一、洛桑联邦理工学院的Tobias Kippenberg教授说,他主导的工作推动了频率梳的研究。“频率梳可提供各种不同波长的光波,这些光波在可以在同一个光子芯片中独立地进行运算。”

明斯特大学的Wolfram Pernice是本项研究负责人之一,同时也是本文的主要共同作者。他说:“在机器学习领域,光学处理器可加速处理任务,可以高速度、高处理量来处理复杂的数学运算。光处理器比利用电信号传输数据的传统芯片快得多,如显卡和张量处理单元等专用硬件等。”

设计和制造完光子芯片后,研究人员们在一个识别手写数字的神经网络上进行了测试。神经网络是机器学习领域的一个概念,受到生物学的启发,主要用于图像或音频数据的处理。“识别图像中边缘需要进行卷积运算,这种输入数据与一个或多个滤波器之间的卷积运算非常适合我们的矩阵架构。”牛津大学材料系的Johannes Feldmann说。牛津大学的Nathan Youngblood补充道:“利用波分复用可以实现前所未有的高数据速率和高计算密度(即单位处理器面积上进行的运算)。”

“这项研究充分体现了欧洲国家之间的研究合作。” 埃克塞特大学的David Wright说,他是资助此项研究的欧盟FunComp项目负责人。“虽然参与合作的每个研究小组都有自己领先世界的长处,但正是所有这些结合在一起,才实现了这项研究成果。”

此项研究发表在本周出版的Nature上,具有广阔的应用前景:数据同步处理能力更高的人工智能(同时意味着更加节能),预测更精准、数据分析更精确的大神经网络,使用大量的临床数据进行诊断,自动驾驶汽车传感器数据的快速分析,以及拥有更大存储空间、更强计算能力以及更多应用程序的软件的云计算基础设施等。

原文见:J. Feldmann, N. Youngblood, M. Karpov, H. Gehring, X. Li, M. Stappers, M. Le Gallo, X. Fu, A. Lukashchuk, A.S. Raja, J. Liu, C.D. Wright, A. Sebastian, T.J. Kippenberg, W.H.P. Pernice, H. Bhaskaran. Parallel convolution processing using an integrated photonic tensor core. Nature 07 January 2021. DOI: 10.1038/s41586-020-03070-1。

客服热线:

客服热线: